第二十四篇 DenseNet——模型讲解

创始人

2025-05-29 17:04:42

0次

摘要

在深度学习网络中,随着网络深度的加深,梯度消失问题会愈加明显,目前很多论文都针对这个问题提出了解决方案,比如ResNet,Highway Networks,Stochastic depth,FractalNets等,尽管这些算法的网络结构有差别,但是核心都在于使用shotcut将浅层和深层链接起来。那么DenseNet是怎么做呢?延续这个思路,那就是在保证网络中层与层之间最大程度的信息传输的前提下,直接将所有层连接起来!整体架构如下图:

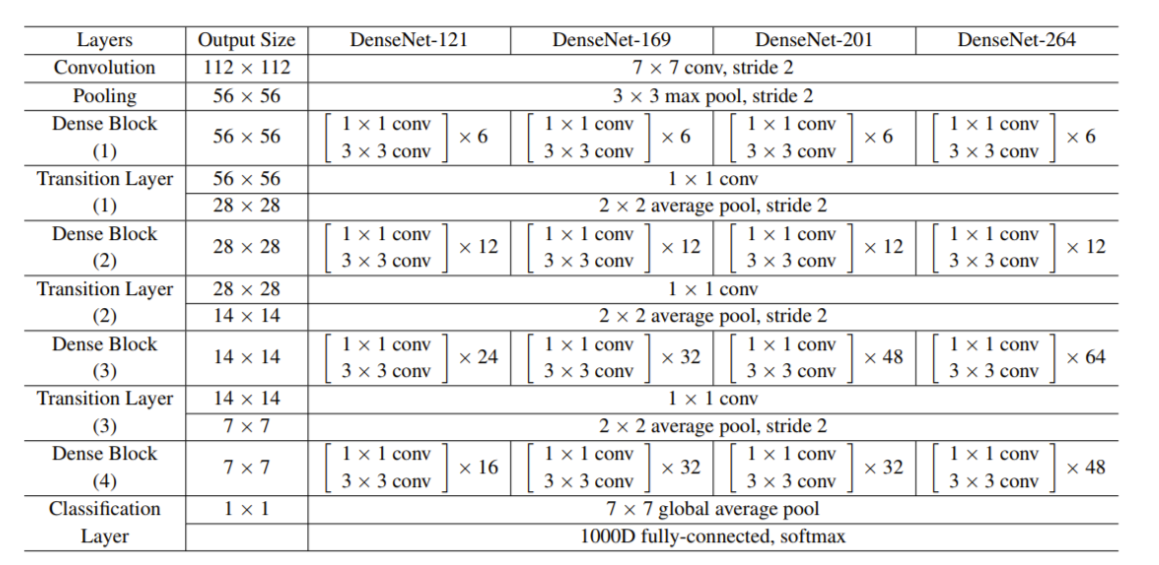

参数结构如下表:

DenseNet的优点:

- 减轻了梯度消失。

- 加强了feature的传递,更有效地利用了feature。

- 一定程度上较少了参数数量。

DenseNet有个缺点,就是特别的消耗显存,不过在后期的模型中修改了,但是这种连接方式和ResNet相比,显存的占用还是很明显。近几年,显卡的技术飞速发展,显存提升很大,所以这个缺点可以忽略!

作为CVPR2017年的Best Paper,DenseNet值得我们深入研究研究!

Dense Block

我们以第一个De

下一篇:计算机操作系统之信号量与死锁

相关内容

热门资讯

linux入门---制作进度条

了解缓冲区 我们首先来看看下面的操作: 我们首先创建了一个文件并在这个文件里面添加了...

C++ 机房预约系统(六):学...

8、 学生模块 8.1 学生子菜单、登录和注销 实现步骤: 在Student.cpp的...

JAVA多线程知识整理

Java多线程基础 线程的创建和启动 继承Thread类来创建并启动 自定义Thread类的子类&#...

【洛谷 P1090】[NOIP...

[NOIP2004 提高组] 合并果子 / [USACO06NOV] Fence Repair G ...

国民技术LPUART介绍

低功耗通用异步接收器(LPUART) 简介 低功耗通用异步收发器...

城乡供水一体化平台-助力乡村振...

城乡供水一体化管理系统建设方案 城乡供水一体化管理系统是运用云计算、大数据等信息化手段...

程序的循环结构和random库...

第三个参数就是步长 引入文件时记得指明字符格式,否则读入不了 ...

中国版ChatGPT在哪些方面...

目录 一、中国巨大的市场需求 二、中国企业加速创新 三、中国的人工智能发展 四、企业愿景的推进 五、...

报名开启 | 共赴一场 Flu...

2023 年 1 月 25 日,Flutter Forward 大会在肯尼亚首都内罗毕...

汇编00-MASM 和 Vis...

Qt源码解析 索引 汇编逆向--- MASM 和 Visual Studio入门 前提知识ÿ...

【简陋Web应用3】实现人脸比...

文章目录🍉 前情提要🌷 效果演示🥝 实现过程1. u...

前缀和与对数器与二分法

1. 前缀和 假设有一个数组,我们想大量频繁的去访问L到R这个区间的和,...

windows安装JDK步骤

一、 下载JDK安装包 下载地址:https://www.oracle.com/jav...

分治法实现合并排序(归并排序)...

🎊【数据结构与算法】专题正在持续更新中,各种数据结构的创建原理与运用✨...

在linux上安装配置node...

目录前言1,关于nodejs2,配置环境变量3,总结 前言...

Linux学习之端口、网络协议...

端口:设备与外界通讯交流的出口 网络协议: 网络协议是指计算机通信网...

Linux内核进程管理并发同步...

并发同步并发 是指在某一时间段内能够处理多个任务的能力,而 并行 是指同一时间能够处理...

opencv学习-HOG LO...

目录1. HOG(Histogram of Oriented Gradients,方向梯度直方图)1...

EEG微状态的功能意义

导读大脑的瞬时全局功能状态反映在其电场结构上。聚类分析方法一致地提取了四种头表面脑电场结构ÿ...

【Unity 手写PBR】Bu...

写在前面 前期积累: GAMES101作业7提高-实现微表面模型你需要了解的知识 【技...